Zuletzt aktualisiert am 14. Januar 2023.

Oder: Passives Einkommen mal anders 😉

Es gibt eine ganze Reihe vielversprechender Projekte rund um das Web3, Crypto und Dezentralisierung. Eines davon ist das Storj-Projekt, bei dem man grob gesagt eigenen nicht genutzten Speicherplatz vermieten kann und damit ein kleines Taschengeld verdienen kann. Im Folgenden möchte ich mein “Storj-Farm” einmal vorstellen.

Ein paar Infos vorweg:

- Kein Get-Rich-Quick Projekt

- Storj-Nodes brauchen Zeit, sie füllen sich nur langsam

- Ein möglicher verdienst summiert sich lange auf, bis er ausgezahlt wird

Wie funktioniert Storj eigentlich?

Im Grundsatz ist das ganz einfach: Privatnutzer stellen ihren überschüssigen Speicherplatz durch einen “Storj-Node”, einen “Knoten” im Storj-Netzwerk zur Verfügung. Dieser Speicher kann dann von Storj-Kunden gemietet und genutzt werden.

Jetzt kann man natürlich zurecht einwerfen: “Moment, meine Daten liegen auf anderen privaten Festplatten?”. Wie steht es da um den Datenschutz? Und was ist, wenn der Node, der meine Daten speichert, offline geht? Das ist bei einem Privat-Computer nun wirklich nicht unwahrscheinlich, oder?

Das sind berechtigte Fragen, die sich aber leicht beiseite schieben lassen:

Der Weg einer Datei vom Upload zum Speicher

Wenn eine Datei hochgeladen wird, wird sie zunächst verschlüsselt und dann in viele kleine Teile gesplittet. Dann wird die Datei auf eine Vielzahl an Nodes im ganzen Storj-Network verteilt. Dadurch ist sichergestellt, dass Niemand ausser dem Besitzer Daten einsehen kann, denn ein Algorithmus stellt sicher, dass nie so viele Teile eines Files auf einem Node liegen, dass es wiederhergestellt werden kann. Und es ist algorithmisch sichergestellt, dass alle Daten immer redundant vorliegen. Fällt ein Node aus, sind die Daten noch auf anderen Nodes vorhanden und werden – durch die sog. Satellites erneut auf andere Nodes kopiert, sodass immer eine gleichbleibende Redundanz gewährleistet ist.

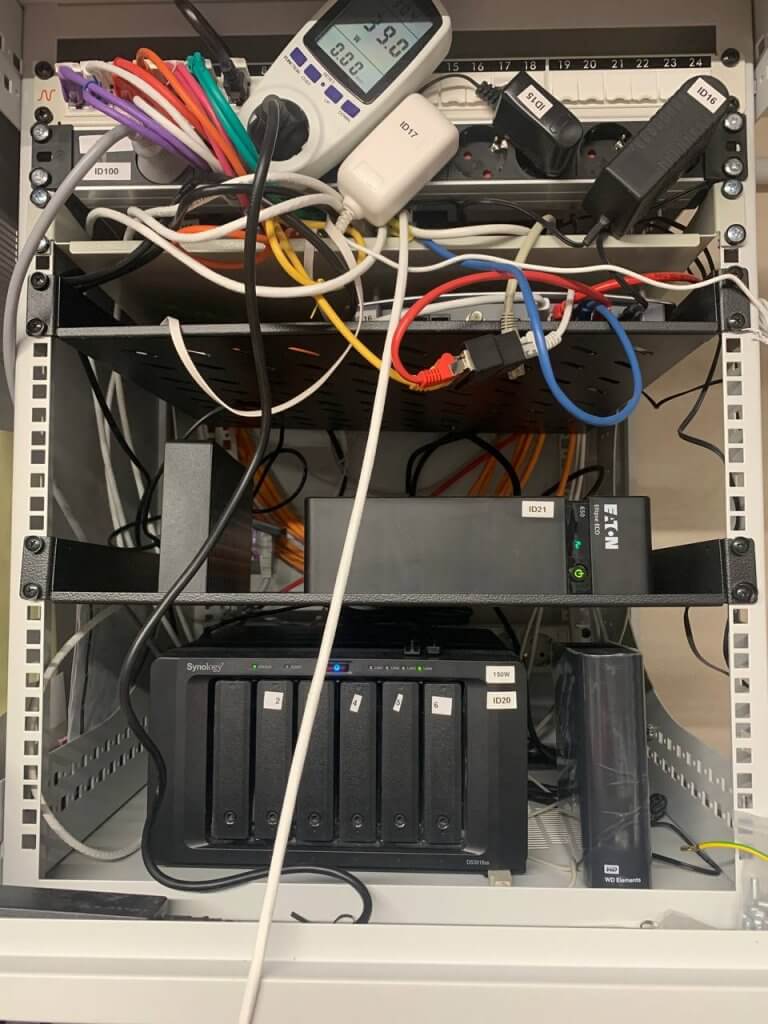

Die technischen Daten meines Storage-Rigs im Detail

Die folgenden Daten beziehen sich auf den Stand von Juni 2022:

- Speicherplatz: >250TB

- Anzahl Hosts/Rechner: 3

- Anzahl HDD:

- Anzahl /24 IP-Adressen: 28

- Stromverbrauch in Summe: 8,6 kWh/24 Stunden (360 Watt Leistungsaufnahme)

- Effizienz (Stromverbrauch pro TB):

- Aktueller Traffic: > 10TB pro Monat

- Internetanbindung 1:

- Internetanbindung 2 (Mobilfunk): 200MBit/s (Down) / 30 MBit/s (Up)

Der Speicher: > 250TB auf externen Festplatten.

Das Gehirn: 3 Recheneinheiten.

Ich betreibe auf dem Storage-Rig aktuell 31 Nodes.

Live-Statistiken zur Bandbreitenauslastung oder dem belegten Speicher auf dem Storage-Rig findest du hier.

Der Ausblick

Im aktuellen Ausbaustatus habe ich eine weile Ruhe. Aber das soll nicht das Ende sein. Wenn der Speicherplatz meines Rigs belegt ist, habe ich durchaus vor, weitere Festplatten zu ergänzen. Der limitierende Faktor ist dann leider in erster Linie meine Internetanbindung. Ich habe keinen Glasfaseranschluss, sondern nur VDSL. Das heisst mein Upload ist hier auf 40mbit/s begrenzt. Zusätzlich habe ich noch eine LTE-Verbindung, die ungefähr die gleiche Bandbreite liefert, zur Verfügung.

Da Glasfaser nach wie vor leider nur Zukunftsmusik sein wird, setze ich große Hoffnungen auf 5G-Mobilfunk – den O2 gerade hier ausgebaut hat.

Du willst wissen, ob sich ein Storj-Storage-Rig auch für dich lohnen kann? Dann rechne dir einfach grob aus, was dein Rig “verdienen” kann: Zum Online-Rechner.

Ein paar Lessons Learned

Netzwerkmanagement und -Planung nicht vergessen (QoS)

Hat man vermutlich zunächst gar nicht so direkt auf dem Schirm, aber auch wenn der Traffic eines einzelnen Nodes zunächst gar nicht so hoch erscheint, so summiert sich bei mehreren Nodes doch ein gewaltiger Datendurchsatz zusammen (und perspektivisch beim Wachstum von Storj sollte das natürlich noch mehr werden), der durchaus das eine oder andere Heimnetz oder erst Recht die Internetverbindung an ihre Grenzen bringen kann. Bei mir äußerte sich das z.B. in Beschwerden der Familie, dass zu Stoßzeiten, wenn viel Storj-Traffic durch das Heimnetz floss, es Probleme mit Alexa oder Netflix kam.

Das Ganze lässt sich einfach mit QoS regeln. Kurz und knapp sollte man dafür sorgen, dass Realtime-Traffic oder Traffic, der für die Zufriedenheit der Familie oder andere – wichtigere – Dienste genutzt wird, priorisiert wird.

Das lässt sich theoretisch sogar mit einer Fritzbox realisieren, ich nutze dafür aber zum Beispiel einen Ubiquiti-Router, der zugleich eine Ausfallsicherheit und Lastmanagement für die Internetverbindung übernimmt.

Skalierbarkeit beachten

Skalierbarkeit spielt bei einem Storage-Rig eine maßgebliche Rolle – in vielerlei Hinsicht.

-> Festplatten

Wer viel Speicher bereitstellen möchte, der braucht viele Festplatten. So weit, so gut. Für viele Festplatten eignen sich in der Regel Festplattenkäfige oder aber “alte” Server von Ebay (diese verbrauchen aber meist sehr viel Strom).

Die Größe der Festplatten ist zudem entscheidend. Denn eine Festplatte ist ein mechanisches Gerät und verbraucht nahezu gleich viel Strom – egal, ob 4TB oder 18TB Speicherplatz vorhanden sind. Auch wenn die Anschaffungskosten etwas höher sind, lohnen sich auf Dauer daher auf jeden Fall eher größere Festplatten.

Meine Grundregel ist, ich kaufe keinen Festplatten mehr, die weniger als 12TB groß sind und ich kaufe erst ab einem Preis von maximal 15€ / TB.

Ich fahre die Low-Budget-Variante: Meine Festplatten sind allesamt herkömmliche externe USB-Festplatten. So spare ich mir Vorrichtungen und Festplattenkäfige.

-> Stromversorgung

Jede externe Festplatte benötigt Strom. Ebenso jeder Host. Daher muss a) für eine ausreichende Stromversorgung gesorgt sein, damit keine Sicherung fliegt und b) müssen genug Schuko-Steckdosen vorhanden sein, da jede Festplatte ein eigenes Netzteil besitzt.

Achtung: Bitte auf keinen Fall einfach etliche Mehrfachstecker hintereinander stecken. Ich greife auf eine explizit steckbare Lösung (hier wird auch der Schutzleiter durch Wieland-Verbindungen weitergegeben) der Firma Bachmann (“Step”).

-> Kühlung

Zwar ist ein Storage-Rig etwas ganz anderes als ein Mining-Rig mit Grafikkarten, das gut und gerne ganze Häuser heizen und mehrere KW Strom in Wärme umwandelt. Aber auch Festplatten (und die Hostmaschinen) verbrauchen Strom und haben eine gewisse thermische Verlustleistung: Sie erzeugen Wärme. Und diese Wärme nimmt mit der Anzahl der Geräte und der Leistungsaufnahme zu. So kann es schnell sehr warm werden. Was im Winter einen gewissen Heizeffekt hat, stellt im Sommer eine reale Gefahr der Überhitzung und damit des Ausfalls von Hardware dar. Nicht umsonst haben professionelle Rechenzentren ein ausgeklügeltes Kühlsystem. Aber ggf. notwendige Klimaanlagen stellen eine erhebliche Investition und einen zusätzlichen Stromverbrauch dar. Für mich kommt das nicht infrage.

Gesegnet ist daher jeder, der wie ich einen kühlen Keller zur Verfügung hat. Im heißen Sommer (aktuell bis zu 35 Grad) bleibt der „Serverraum“ trotzdem bei maximal angenehmen 23 Grad.

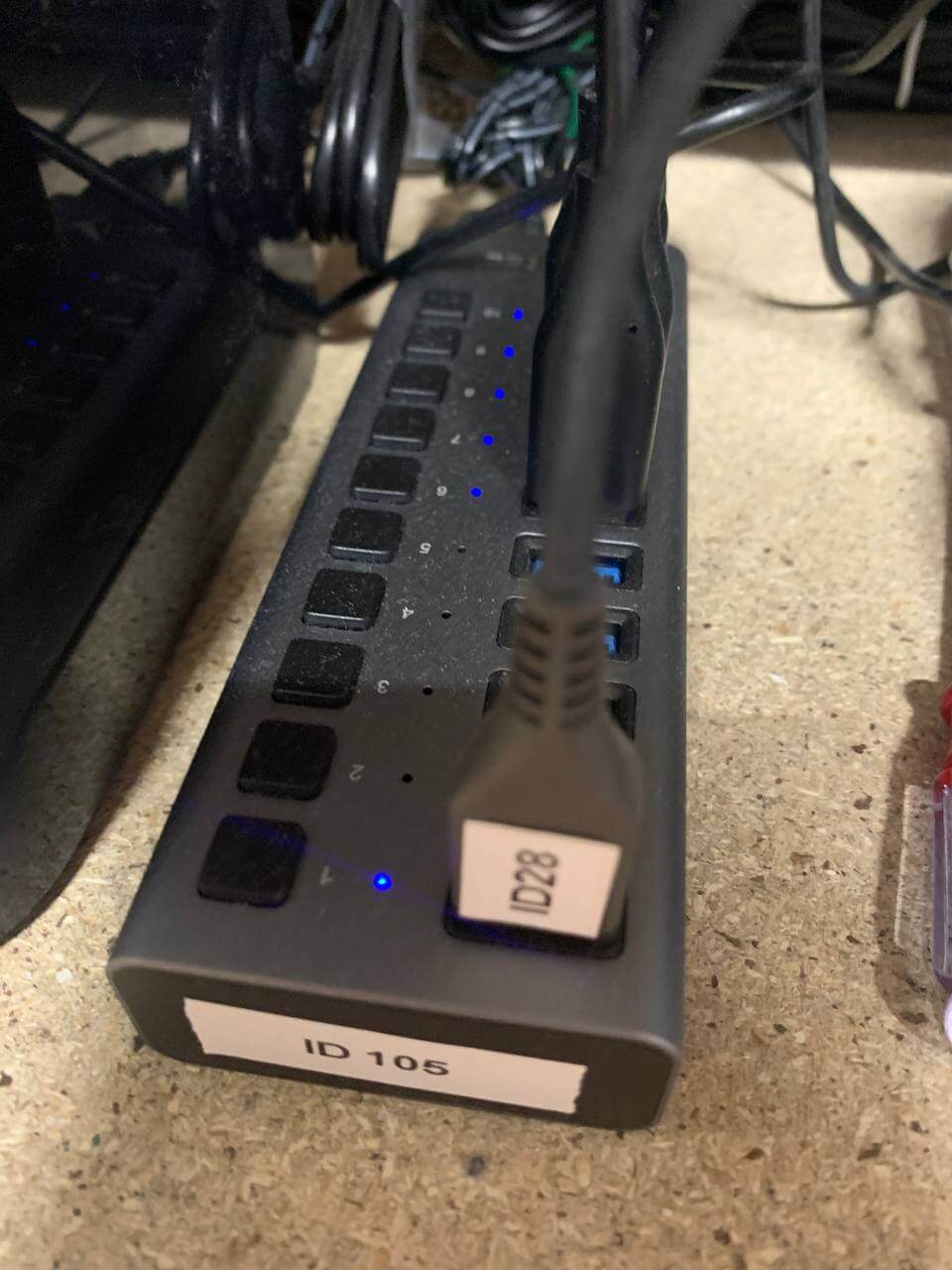

->Netzwerk

Jeder Storagenode benötigt – je nach Auslastung – einen gewisse Bandbreite. Primär interessant ist hier die Internetanbindung, da die Daten, die auf den Storagenodes gespeichert (und abgerufen) werden, über das Internet übertragen werden. Sekundär sollte aber auch das Heimnetz entsprechende Kapazitäten aufweisen. Gerade wenn einige Nodes betrieben werden, die ggf. zwischendurch auf andere Datenträger migriert werden müssen, sollten leistungsfähige Switches und LAN-Kabel mit mindestens 1GBit/s verwendet werden.

->Rechenleistung/Hostmaschinen

Aktuell sind in mein Rig 3 Hosts integriert. Die Hosts verfügen jeweils über einen SSD-Cache und sind die Basis, auf denen für jeden Storagenode ein Docker-Container läuft sowie eine virtuelle Lubuntu-Maschine, die über VPN ein anderes /24-IP-Netz anbindet.

So kommen einige VMs zusammen, die in Summe einiges an Arbeitsspeicher benötigen. Daher verfügen die Hostmaschinen in Summe über knapp 120GB RAM.

Tipp: Einer meiner Hosts nutzt eine spezielle Energiespar-CPU auf Basis eines i7. Der Stromverbrauch ist hier signifikant niedriger als beim Standard i5-Pendant, der bei einem anderen Host zum Einsatz kommt.

Effizienz

Ein ganz wichtiges Thema – vor allem bei hohen Energiepreisen, wie wir sie hier in Deutschland haben – ist die Effizienz des Systems. Letztlich kann man vereinfacht die Speicherkapazität in Relation zur Leistungsaufnahme (also dem Stromverbrauch) setzen und so eine Kennzahl für die Effizienz erhalten:

Watt pro TB

Mein Rig verbraucht aktuell knapp 400 Watt Strom und bietet 250TB Speicher. Das bedeutet. Pro TB verbrauche ich 1,6 Watt. Das ist schon in Ordnung, lässt sich aber natürlich noch verbessern. Mit jeder zusätzlichen Festplatte, die ca. 8 Watt verbraucht und mindestens 12 TB Speicher bietet, wird das Rig etwas effizienter. Allerdings laufen auf dem Rig auch noch andere Dienste, die wir hier außer Acht lassen und die die Rechnung zusätzlich positiv beeinflussen.

Nun ist es aber natürlich so, dass nicht der gesamte Speicher des Rigs direkt von Storj genutzt wird. Es dauert eine ganze Weile, bis der Speicher belegt ist. Freier Speicher wäre nun im Prinzip verschenkt. Damit der Speicher nicht einfach nur rumliegt, nutze ich den überschüssigen Speicher zum Farmen von Chia. Das gibt dann immerhin noch ein kleines Taschengeld 😉

Weitere Gedanken zur Effizienz

Theoretisch liesse sich die Effizienz durchaus noch steigern, so habe ich im letzten Winter eine Innendämmung des Kellerraumes installiert, sodass mein Storage-Rig mittlerweile genug Abwärme liefert, um im Winter den Raum zu heizen (so spare ich mir die vorher installierte Strom-Heizung). Theoretisch ließe sich nun mit einer Brauchwasserwärmepumpe die Wärmeenergie aus dem Raum ziehen und zur Warmwasseraufbereitung für das Haus nutzen. Vielleicht ein Projekt für später 😉

Weitere Bilder meines Storage-Rigs

Maximilian

Danke für den detaillierten Beitrag.

Wie hast du das mit den VPNs realisiert? Lohnt es sich hier auf Nord-VPN und co. zu setzen oder hast du mehrere Server bei Hostinganbietern? Ich habe mir einen Server bei Hetzner gemietet für ein VPN bei einem anderen Projekt, dies gibt mir aber nur eine andere IP-Adresse. Und 4€ Pro IP ist dann doch recht teuer.

Ich habe ein altes Festplattenbay mit 15 3TB SAS Festplatten die nicht genutzt werden, allerdings denke ich mir dass es nicht sehr lukrativ sein kann da es so viel Strom verbraucht, meinst du es lohnt sich trotzdem, da die Platten ja schon vorhanden sind?

Jan-Dirk

Hallo Maximilian,

ich nutze keine VPN-Dienstleister wie Nord-VPN und Co. Dort kriegt man in der Regel ja immer wieder wechselnde IP-Adressen bzw. selbst wenn man dort eine feste IP buchen kann, ist die Wahrscheinlichkeit hoch, dass es im selben /24-Netz schon andere Nodes gibt 😉

Ich habe mir im Wesentlichen vServer und VPS gemietet und nutze deren IP-Adresse mittels OpenVPN.

Beste Grüße

Jan-Dirk

Matthias

Möchten Sie uns mitteilen, welchen VPS-Anbieter Sie verwenden?

Jan-Dirk

Es handelt sich um einen größeren Anbieter im deutschsprachigen Raum, wer sich die Screenshots genauer anschaut, der kann dann darauf kommen. So direkt möchte ich es hier nicht verraten, sorry ;))

Robin

Du hast mich Inspiriert das auch auszuprobieren. Bin bei knapp 60TB natürlich noch nicht annährend voll. Nutze drei VPS mit OPVPN um das ganze zu befüllen. Auf was für eine Wallet transferierst du das Ganze? Habe bei Metamask feststellen müssen das die transaktionsgebühren irre hoch sind. Wie bekomme ich die Storj am günstigsten(oder besten)in Euro umgewandelt?

Jan-Dirk

Klasse, freut mich, dass du auch dabei bist und das Ganze skalierst 😉

Ich nutze MEW (MyEtherWallet), klassisch im Ethereumnetzwerk als ERC-20 Token, keine Experimente mit Polygon zksync oder so.

Ich warte immer, bis sich etwas größere Beträge angesammelt haben und transferiere diese dann zu einer Börse (z.B: Binance). Dort kann ich dann verkaufen und die EUR auszahlen lassen.

So fallen die (doch stark schwankenden) Transaktionsgebühren nicht so ins Gewicht.

philip

Hast du 28 verschiedene vps gemietet?

oder habe ich etwas falsch verstanden

Jan-Dirk

Nein, das ist schon richtig so 😉

Beste Grüße

Jan-Dirk

Paul

Hallo und danke für die vielen Infos,

ein paar Dinge die sich mir noch nicht erschließen, welchen Vorteil hat 28 VPS zu haben, gegenüber alles bei sich zu Hause lokal? Da der Traffic ja eh über die eigene Leitung geht? Oder welchen Vorteil hat es, viele kleine Nodes zu haben gegenüber einer größeren?

Für die IP-Adressen würde es doch auch gehen über Dyndns eine Weiterleitung einzurichten?!

VG

Paul

Jan-Dirk

Hallo Paul,

vielen Dank für deinen Kommentar 😉

Ja, der Traffic geht komplett über die eigene Leitung, das ist vollkommen richtig.

Allerdings verteilt das Storj-Netzwerk seinen Traffic so, dass in jedem /24-Adressbereich nur maximal ein Teil eines Files landet.

Daher werden alle Nodes in einem /24-Netzwerk wie ein großer Node betrachtet.

Alle Nodes in unterschiedlichen /24-Netzen werden aber als einzelne Nodes betrachtet. Und alle Nodes bekommen gleich viel Traffic. Das bedeutet, ich bekomme mit 28 VPNs, aka 28 unterschiedlichen /24-Netzen den 28-fachen Traffic (ca.) als wenn alle Nodes in einem /24-Netzwerk laufen würden.

Beste Grüße

Jan-Dirk

Daniel

Super Beitrag. Hab mir jetzt all deine Beiträge bezüglich StorJ durchgelesen und du hast mir einige meiner Vermutungen bestätigt. Ich finde auch super das du die Nodes einfach über mehrere IP‘s laufen lässt.

Ich hab mich vor einigen Wochen auch endlich entschieden eine Node auf zu setzen. Ich verfolge das jetzt schon einige Jahre, hatte aber zu große Angst das da jemand Illegale Files auf meiner Node gelagert hat & was dann auf mich zu kommen könnte. Aber endlich hab ich mich ran getraut und hab einige Tage drüber nachgedacht wie ich das ganze beschleunigen könnte.

Meine Idee ist quasi die selbe wie du es umgesetzt hast.

Nur würde ich nicht opnVPN sondern WireGuard nutzen. Läuft deutlich schneller.

IP‘s würde ich auch einige residential IP‘s nutzen wollen um diese ebenfalls für HoneyGain etc. zu nutzen. Einfach ein PI oder Travel Router bei Verwandten aufgestellt und jährlich einen Beitrag abmachen und fertig.

Normale VPS IP‘s werde ich mir auch zulegen.

Ich hatte Angst das ich mit meinen 50 Mbit up & download schnell an meine Grenzen stoße, wenn ich aber sehe wie viel nodes du laufen hast, mach ich mir da keine Sorgen. Im nächsten Jahr ist eine 1000er Leitung geplant mit 200Mbit Upload. Ich denke da sollte ich dann dicke mit hinkommen.

Allerdings würde ich das ganze ein wenig „professioneller“ laufen lassen mit 19“ Case‘s und die meisten platten werden auch via SATA verbunden.

Wundert mich ehrlich gesagt dass das auch via USB super bei dir läuft.

Ich frage mich allerdings wie du das mit Backup‘s etc. Regelst? Ich bezweifle das die platten bei dir im Raid laufen oder irre ich mich da?

Was machst du wenn mal 1 Platte ausfällt? Verzichtest du dann auf die Node?

Ich plane mindestens 5 Platten im RaidZ also via ZFS zu nutzen. So kann 1 ausfallen ohne das ich mir sorgen um die Einnahmen machen muss. Wird nachträglich aber auf RaidZx2 erweitert, so das auch mal 2 Platten ausfallen dürfen.

Bezüglich deines VPS anbieters bin ich auch gespannt gewesen ob di vielleicht jemanden gefunden hast der günstig ist, allerdings konnte ich in keinen deine Beiträge einen Screenshot finden der drauf hinweist. Ich werde morgen aber mal genauer suchen 😀

Wünsche dir noch viel Erfolg damit & mach bloß weiter so. Da gibt es sicherlich noch einiges zu optimieren (Y)

Jan-Dirk

Hallo Daniel,

vielen Dank für deinen Kommentar und dein Feedback 😉

In der Tat ist es ja eher hobby und man kann einfach (gerade wenn man das Ganze etwas skaliert) noch eine Menge über Flaschenhälse, Bandbreiten, usw usf lernen 😉

Wireguard ist in der Tat die leichtgewichtigere Lösung, ich habe mich einfach aus Effizienzgründen für OpenVPN entschieden, da man hier mit dem OpenVPN-Access-Server schnell einen Endpunkt erstellt hat. Dann habe ich mir für die Clients einmal ein VM-Image erstellt und das wird eben seitdem immer wieder genutzt 😉

Allerdings ist das mit mittlerweile weit über 30 VMs schon ein riesiger und unsinniger Overhead. Da docker hier eine wesentlich leichtgewichtigere Lösung darstellt und für jeden Container einen eigenen virtuellen Netzwerkstack bereitstellt, werde ich demnächst, wenn sich mal etwas Zeit findet, das Projekt angehen, die Clients in einzelne Docker-Container zu packen.

Die Idee mit dem Travel-Router bzw. die Anbindung von Bekannten finde ich eigentlich auch sehr charmant, aber meine “Investments” beschränken sich rein auf neue Festplatten, also Speicher und Server(zubehör).

Die Buchung eines VPS ist einfach einfacher als das Aufstellen eines Routers und die ganzen Erläuterungen bei Bekannten 😉

Ich habe aktuell im Download Peaks von 150MBit/s, im Upload knapp 100MBit/s, in der Regel deutlich weniger. Mittlerweile habe ich einen 5G-Hybrid-Anschluss der Telekom, der mir Bandbreiten bis 150MBit/s im Upload und 450MBit/s im Download ermöglicht (im Übrigen ein wirklich tolles und stabiles Produkt der Telekom). Vor ein paar Tagen lag der Brief der deutschen Glasfaser zur Nachfragebündelung im Briefkasten. Das wäre dann natürlich der Traum und würde erhebliche Zukunftssicherheit mitbringen 😉

In Summe kann ich tatsächlich sagen, dass die USB-Anbindung erstaunlich stabil ist, ich habe wirklich sehr sehr selten Probleme, hat mich auch gewundert.

Ehrlicherweise bin ich aber mittlerweile auch auf SATA-Multiplier oder Expansion-Boxes für die Synology-NAS umgestiegen *duckundweg*.

Im nächsten Schritt denke ich darüber nach, die “Server”-Hardware gegen einen effizienten ESXI-Host auszutauschen. Mein Ziel ist eine Effizienz von 1W Leistungsaufnahme pro TB.

Passend dazu wird dann das Balkonkraftwerk aufgerüstet 😉

Ich denke nur mit diesem Mix lässt sich das Ganze auch zukünftig zumindest nicht mit Verlust hier in Deutschland betreiben.

Die Backup Thematik:

Ganz einfach. Ich backupe nur die Hosts, weil dort ein Ausfall potentiell katastrophale Folgen für alle Nodes hätte.

Ansonsten läuft ein Node (maximal 2-3) auf einer HDD. Fällt die HDD aus, ist der Node verloren. Das ist in meiner Kalkulation berücksichtigt.

Raid und Backup lohnen sich einfach finanziell nicht. Zumal das Storj-Netzwerk ja eingebaute Redundanz hat und einen ausgefallenen Node problemlos ersetzen kann.

Mir ist bisher erst ein Node wirklich verloren gegangen, und da war mein Setup noch einmal wesentlich rookiehafter xD

In der Regel kündigen sich Ausfälle bei den HDDs mit Verbindungsabbrüchen und Filesystemfehlern an. Dann kann man den Node in der Regel noch auf eine andere Festplatte kopieren und retten.

ZFS ist glaube ich auch ein guter Weg, ich meine einige größere Fische betreiben ihre Setups damit.

Mittlerweile nutze ich ein paar verschiedene Anbieter für die VPS 😉

Beste Grüße aus Bielefeld

Jan-Dirk

Paul

Hallo Jan-Dirk,

Bielefeld klingt gut, bin auch aus Bielefeld. Habe inzwischen auch aufgerüstet mit 4x8TB Platten.

Bin im Moment am beobachten wie sich meine Nodes entwickeln. Werde die Tage noch 2x2TB zum “anzüchten” hinzufügen.

Für die VPS habe ich auch einen sehr guten und sehr günstigen Hoster gefunden und mit OpenVPN ist das Ding in ein paar Minuten eingerichtet.

Ein paar Fragen hätte ich allerdings noch:

#1: du schreibst, du willst umbauen von VMs auf Docker, was ich da aber nicht verstehe ist. Wie kann man da dann die einzelnen VPN Clients auf den passenden Container routen? Die müssten dann ja alle parallel auf dem Host laufen, oder wie muss ich mir das vorstellen?

#2: Nutzt du die 10% overhead Regel ein? Oder vergibst du den kompletten Speicher?

#3: Welche Virtualisierungsumgebung nutzt du? Ich habe bei mir im Moment alles auf Proxmox aufgebaut

Jan-Dirk

Hallo Paul,

die Welt ist klein 😉

Ein kleiner Tipp: Ich habe zu beginn auch immer angefangen, die Nodes auf kleinen HDDs anzuzüchten. Eigentlich sehr effizient. Spätestens als ich aber angefangen habe, HDDs zu kaufen, habe ich immer versucht die größten Platten zu bekommen, da diese eine wesentlich bessere Energieeffizienz aufweisen und das kommt bei einem größeren Rig durchaus zum Tragen. Außerdem habe ich damit angefangen, auch neue und kleinere Nodes alleine auf eine z.B. 20 oder 22TB HD zu legen (und den freien Speicher ggf. mit Chia-Plots zu belegen).

Wieso? Ganz einfach, je größer die Nodes werden, desto mehr Files beherbergen sie (und ich meine WIRKLICH viele Files ;)). Das Kopieren und Umziehen eines Nodes auf eine andere HDD ist mit viel viel viel Geduld (mehrere Tage) verbunden.

Um mir diese Nerven zu sparen, setze ich meine Nodes mittlerweile direkt auf große HDDs.

Freut mich, dass du einen günstigen Hoster gefunden hast, ich hoffe, wir “klauen” uns jetzt nicht gegenseitig die /24-Netze ;))

Zu 1)

Du kannst jeweils in einem Container einen Client laufen lassen mit einem virtuellen Netzwerkstack. Dann kannst du den Container mit einem anderen Container (z.B. eben dem des Storagenodes) linken und/oder in das gleiche Docker-Netzwerk setzen.

Alternativ kannst du auch einen Proxy-Container dazwischen schalten, das ist aber – zumindest in meinem Kopf – ein Overhead, der nicht notwendig ist.

Und ja, die Container müssen parallel auf dem gleichen Host laufen. Laufen sie auf unterschiedlichen Hosts, brauchst du einen Proxy-Container.

Zu 2)

Ja, die halte ich ein und das würde ich auch unbedingt empfehlen. Gerade in letzter Zeit gab es größere Deletes und das Trash-Verzeichnis ist sehr voll gewesen. Bei einzelnen Nodes wurden die 10% voll ausgereizt.

Und wenn die HDD voll ist, aber noch freier Speicher suggeriert wird, bekommst du Files, die du nicht speichern kannst – das führt im schlimmsten Falle zur Disqualification.

Da “verschenke” ich lieber 10% des Speichers.

Zu 3)

Ich nutze KVM-Virtualisierung. Als Hypervisor nutze ich ESXi oder den VMM von Synology (Da kann man sich schnell einen kleinen Cluster aufbauen).

Mittelfristig habe ich aber schon mit dem Gedanken gespielt, auch auf Proxmox umzusteigen, da es hier eine Unterstützung für die Big-Little-Architektur der modernen (und sparsamen) Intel-CPUs gibt, die bei ESXI nicht vorhanden ist.

Ansonsten nehmen sich die Lösungen denke ich nicht so viel.

Beste Grüße

Jan-Dirk

Paul

Vielen Dank für die Antworten…

Meine mir zugeteilten IP Adressen liegen so weit gestreut, dass es da glaube ich sehr unwahrscheinlich ist, dass wir uns da treffen 😉

Und das mit dem Umziehen hast du auch recht… Ich mache es erst mal so, weil ich die beiden 2TB noch rum liegen habe und noch keine größeren gekauft habe.

Bei switch kommt man aber leider nicht ohne Downtime aus und so brauche ich erst mal paar Tage um wieder auf 100% uptime zu kommen – ich bin grad noch ein bisschen auf Schnäpchensuche was festplatten angeht.

Zu deiner Antwort zu #1:

Habe ich das richtig verstanden? Du hast ein Container als VPN-Client und einen für die Node und die beiden werden über ein virtuelles Netzwerk gelinkt? Dann würde aber die Standardkonfiguration den VPN-Client nicht mehr greifen, sondern man müsste noch eine Route erstellen, damit der Node-Container seinen Traffic über den VPN-Client schickt? Oder schmeiße ich da was durcheinander?

Sorry, aber in der Tiefe hatte ich mit Docker leider noch nichts so viel zu tun…

Viele Grüße,

Paul

Jan-Dirk

Und halt mich mal auch auf dem Laufenden über dein Projekt, ich wünsche dir auch viel erfolg und bin gespannt, wie deine Nodes wachsen 😉

Beste Grüße

Jan-Dirk

Christian

Moin. Cooles Projekt. Bin auch am überlegen bei StorJ “einzusteigen” um einfach die Stromkosten von meinem eh laufenden Homeserver (60 Watt) zu kompensieren.

Aktuell könnte ich drei Nodes durch DynDns und dementsprechend drei unterschiedliche Anschlüsse laufen lassen. 1x bei mir direkt und zwei Nodes über Familie und deren Anschluss. Macht das Sinn als Einstieg?

Habe in vielen Foren gelesen, dass für StorJ keine SMR Festplatten genommen werden sollten, sondern die CMR.

Du scheinst aber alles SMR Platten am laufen zu haben. Sehe ich das richtig?

Besten Dank und Gruß aus Minden 🙂

Jan-Dirk

Hallo Christian,

vielen Dank für deinen Kommentar.

Was vielleicht wichtig ist: Mittels dyndns kannst du zwar deinen 3 Nodes unterschiedliche “Adressen” geben, unterm Strich laufen Sie aber alle unter der gleichen IP und im gleichen /24 Netz. Das bedeutet sie werden vom Storj-Network als ein Node behandelt. Der Traffic wird sich dadurch nicht erhöhen, er wird lediglich auf die 3 Nodes verteilt. Sofern die Nodes am gleichen Anschluss sind.

Wenn du die Nodes an 3 unterschiedlichen Anschlüssen betreibst, ergibt das Sinn, du hast dann 3 unterschiedliche IPs aus vermutlich auch 3 unterschiedlichen /24 Netzen. Hier ergibt dann auch der DynDNS-Ansatz Sinn.

Ich habe nur noch ein paar SMR-Festplatten am Laufen, die ich noch aus einem anderen Chia-Rig übrig hatte, oder die ich gekauft hatte, bevor ich wusste, dass SMR-Drives für Storj nicht gut sind.

Ich kann auf jeden Fall bestätigen, dass du unbedingt CMR-Drives nehmen solltest, da die IO-Last besonders wenn die ganzen Filewalker laufen sehr hoch ist und SMR-Drives hier rgelmäßig zu Problemen führen. Ich würde sie definitiv nicht nachkaufen.

Ich drücke dir die Daumen für dein Projekt, kannst ja gerne mal ein wenig über deine Erfahrungen berichten 😉

Beste Grüße

Jan-Dirk

Christian

Vielen Dank für die Antwort und die Mühe die du dir hier machst 🙂

Ich versuche mich aktuell gerade in die ganze Thematik einzulesen. Habe jetzt erstmal zwei 18TB CMR Platten gekauft 🙂

Bzgl. der drei Anschlüsse war mein Plan eine Node direkt über meinen Anschluss laufen zu lassen. Zu den zwei anderen Anschlüssen würde ich per Wirecard ein VPN Tunnel aufbauen, somit sollten die Nodes dann doch eine andere /24 IP bekommen bzw. eine IPv6 Adresse.

Ob das so klappt, weiß ich nicht.

Hast du die Container direkt mit im Netz oder hast du ein extra IP Netz dafür aufgebaut?

Es wäre super wenn du einmal, vllt in einem extra Beitrag, nochmal auf die Netzwerk-Thematik eingehen könntest. Ich hätte hier auch noch “tausende” Fragen, besonders zu deinem Punkt 1 in einem der oberen Kommentare.

Vielen Dank und beste Grüße,

Christian

Jan-Dirk

Hallo Christian,

ich hatte ohnehin eigentlich mal vor, eine Art “From Zero to Hero” Tutorial rund um eine Node-Farm zu erstellen. Da gehört Networking dann natürlich dazu 😉

Und zu deiner Idee, ja, das klappt 😉

Ich habe einige Nodes mittels VPN mit einer eigenen /24 IP ausgestattet 😉

Beste Grüße

Jan-Dirk

Christian

Hallo Jan,

das wäre super und würde bei vielen Interessierten wahrscheinlich einige Fragen klären 🙂

Eine letzte habe ich aber noch… hast du die Hostmaschinen und damit auch die Container mit bei dir im Netz laufen oder hast du hierfür eine eigene DMZ laufen?

Ich habe irgendwie bedenken die Nodes bzw die Container im eigen LAN zu betreiben.

Danke dir und beste Grüße,

Christian

Jan-Dirk

Hallo Christian,

ich habe einige Nodes (meine ersten) tatsächlich in meinem LAN laufen. Da der Sourcecode für die Storagenode-Software OpenSource ist und öffentlich bei Github (https://github.com/storj) entwickelt wird, sehe ich das tatsächlich als nicht soooo mega schlimm an.

Aber du hast Recht, wenn man es ganz sicher und ordentlich will, sollte man aber tatsächliche beispielsweise mit VLANs oder DMZ arbeiten, so mache ich es auch bei neu aufgesetzten Nodes.

Beste Grüße

Jan-Dirk

Vince

Hallo Jan,

dein Artikel hat mich ebenso bewegt ein paar Nodes aufzusetzen bzw nun aufzustocken. Nun habe ich aber in den Foren gelesen, dass dies wenn es mehrere Nodes über eine Hauptleitung per VPN laufen ,gegen die Nutzungsbestimmungen verstoßen würde. Es soll ja verhindert werden wenn jemand z.b daheim auf einer Leitung 1Petabyte anbietet und die wegfaellt , Störungen im Netz zu vermeiden und widerspricht auch der Dezentralisierung. Hast du alle Nodes auf einer Mail laufen? Theoretisch wenn se feststellen , hier gäbe es einen Verstoß,können se so über doe mail-id alle registrierten Identitys auf einmal disqualifizieren.Ich habe noch keinen Beitrag gefunden, dass jemand deswegen disqualifiziert wurde. Wie sind deine Gedanken dazu? Was machen die aktuellen Auswertungen Statistiken? In deinem Beitrag wo die Übersichten über Grafana zu sehen sind , lassen sich leider nicht alle Bilder laden. Hab’s nun über zwei verschiedene Internetleitungen und drei Endgeräte versucht aufzurufen. Kannst hier vllt noch mal ein Update machen? Hast du auf jedem vps ein Subnetz ohne andere Nodes als Nachbar zu haben? Hab 3Vpn Dienste gemietet drei verschiedene Hoster …und auf einem hab ich schon nen Nachbarn , womit ja der Ingress/egress dann aufgeteilt wird / hab’s parallel gemessen und die Aussage passt …218tb HDD über zwei vpns und sehe bei dem einen doppelte Bandbreite:( Beste Grüße Vince

Jan-Dirk

Hallo Vince,

als ich meine Nodes aufgesetzt habe, gab es die Nutzungsbestimmungen in der Form, dass das “Umgehen” der /24-Regel mittels Wireguard oder VPN untersagt wäre, noch nicht.

Ich habe für alle Nodes die gleiche Domain in der Mailadresse (und auch die gleiche Wallet) genutzt.

Bisher keinerlei Probleme.

Mir ist auch kein Fall bekannt, in dem bereits Nodes deswegen disqualified worden wären, hast du dafür eine Quelle?

PS: Ja, bei den Statistiken muss ich nochmal ran, die laufen noch nicht so stabil 😉

Beste Grüße

Jan-Dirk

Cobra

Hallo,

ich habe schon einen Node der lokal bei mir läuft. Ich will einen zweiten mittels VPS + OpenVPN aufsetzen, allerdings funktioniert da etwas nicht:

OpenVPN scheint zu funktionieren (whatsmyip ergibt die IP von der VPS) aber sobald ich storj mittels docker starte (mit -e ADDRESS=”:28967″ erhalte ich einen error message

contact:service ping satellite failed

“ping satellite: failed to ping storage node, your node indicated error code: 0, rpc: tcp connector failed: rpc: dial tcp :28967: connect: no route to host”

Kannst du mir da weiterhelfen?

Best Grüsse

Christian

Moin nochmal, erste Node läuft. In einem LXC Container unter Docker (Portainer, Wireguard und Node).

Hab ein paar letzte Fragen:

1. Bei weiteren Nodes: Neue Bridge in Docker (auf dem bestehnden LXC Host) erstellen und das Spiel von vorne oder Pro Node auch besser ein neuer LXC Container?

2. Überwachst du nur deine Nodes oder auch die VPS Server?

Besten dank und beste Grüße,

Chiristian