Zuletzt aktualisiert am 19. Februar 2022.

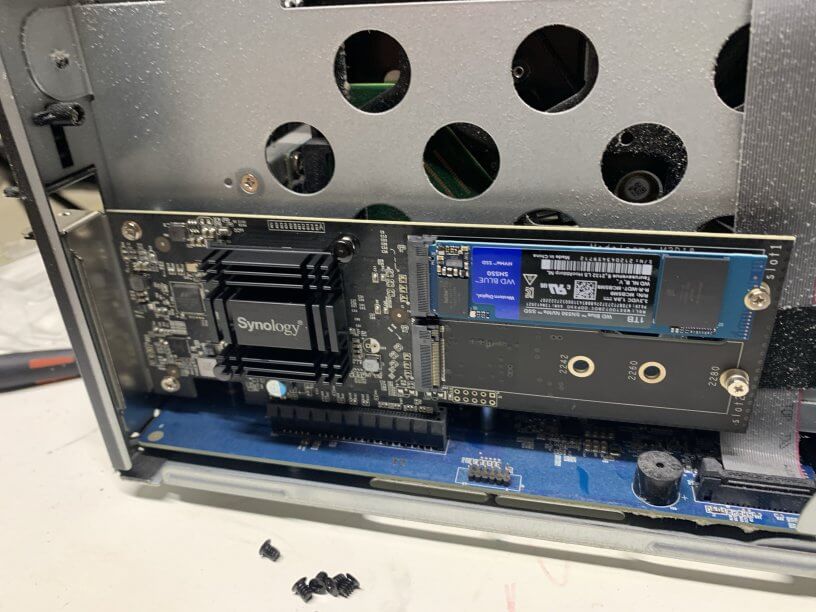

Synology NAS kann man entweder (bei aktuellen Modellen) über integrierte M2 NVME-Slots oder über Adapterkarten wie die M2D18 oder M2D20 mit NVME-SSDs erweitern. Synology sieht den Einsatz aber nur als Cache-Laufwerke vor.

Hier erfährst du, wie du NVME-SSDs als Volume nutzen kannst.

Achtung: Die Verwendung von NVME-SSDs als Volume ist von Synology absichtlich nicht im DSM vorgesehen und wird mit der möglichen Überhitzung der SSDs begründet. Es gibt zudem Berichte von Nutzern, bei denen Daten auf dem neu eingerichteten Volume zwischendurch auf einmal verschwunden waren.

Prinzipiell kann man so gut wie jede NVME-SSD in ein Synology NAS einbauen und nutzen sofern man entsprechende Slots oder Adapterkarten hat. Trotzdem empfiehlt sich ein Blick auf die Kompatibilitätslisten von Synology.

Ich nutze aktuell SN550 SSDs von Western Digital.

- LEISTUNGSFÄHIGE PERFORMANCE: Rüsten Sie Ihren PC mit der benötigten schnellen Leistung auf. Die Crucial P3 Plus liefert Ladezeiten und Datenübertragungen, die 8,9 Mal schneller sind als SATA und 43 % schneller als die schnellsten Gen3-SSDs

- GERÄUMIGER SPEICHER: Mit einer großzügigen Speicherkapazität von bis zu 4 TB bietet die Crucial P3 Plus leistungsstarken Gen4-Speicher für eine Vielzahl von Anwendungen, Programmen, Dateien, Dokumenten, Fotos, Videos und Spielen - und das mit ausreichend Platz.

- SOLIDE SICHERHEIT: Gen4-Technologie, SSD-Verwaltungssoftware zur Leistungsoptimierung und Firmware-Updates geben der Crucial P3 Plus SSD alles, was Sie für Sicherheit und Seelenfrieden brauchen. 5 Jahre beschränkte Garantie und Abwärtskompatibilität mit Gen3 für ultimative Flexibilität

- VERTRAUENSWÜRDIGE TECHNOLOGIE: Hergestellt mit hochwertigem Micron Advanced 3D NAND und getestet und validiert nach den Expertenstandards, die Sie von einem der weltweit größten Hersteller von Flash-Speicher erwarten.

- INNOVATION: Micron stellt seit mehr als 40 Jahren einige der weltweit fortschrittlichsten Speichertechnologien her. Alle Crucial-Produkte werden von Microns Weltklasse-Ingenieurteam entwickelt, um erstklassige Qualität und Zuverlässigkeit zu gewährleisten.

HowTo: NVME-SSDs als Volume

Tipp: Im Zweifel müssen die Befehle mit einem beherzten “sudo” vor dem Kommando ausgeführt werden 😉

1. Vorbereitungen

Um NVMe-SSDs als Volume einzubinden brauchst du auf jeden Fall SSH-Zugriff auf deine Diskstation.

Außerdem ist es unbedingt zu empfehlen, ein Backup aller wichtigen Daten und besser noch des gesamten Systems zu haben.

2. NVME SSD einbauen und Slot herausfinden

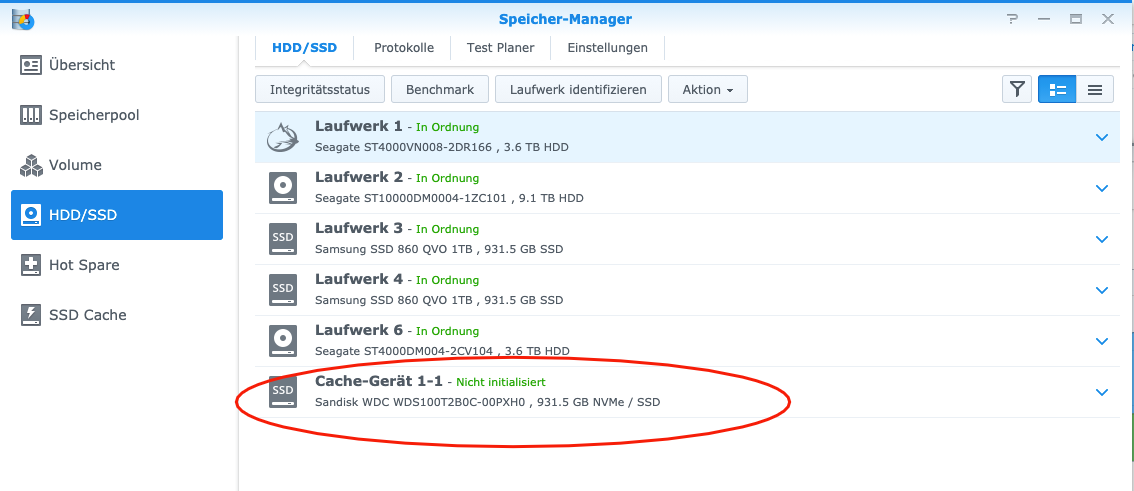

Jetzt kannst du deine NVME-SSD einbauen (und einmal das NAS rebooten). Die SSD sollte nun gefunden werden.

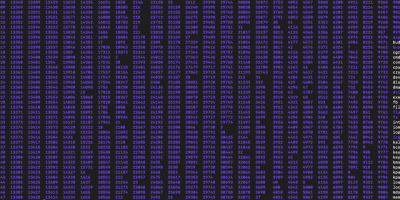

Logge dich nun über SSH auf deiner Diskstation ein und schaue mit folgendem Befehl, in welchem Slot sich die SSD befindet:

ls /dev/nvme*

Das Ergebnis sieht dann z.B. wie auf dem obigen Screenshot der Konsole aus.

Mittels des folgenden Befehls können wir uns für das gewählte Laufwerk (in diesem Falle /dev/nvme0n1) anzeigen lassen und so sicherstellen, dass es sich tatsächlich um das richtige Laufwerk handelt.

fdisk -l /dev/nvme0n1

3. Partition auf NVME-SSD erstellen

Wichtig: Zum Partitionieren nutzen wir ein synology-eigenes Skript. Nur so wird die notwendige Partitionierung erstellt, um die SSD als Volume zu erkennen.

Hier liegt aber auch eine Gefahr: Das Skript erstellt zugleich eine Systempartition, auf der sich u.A. auch das DSM mit befinden wird. Läuft hier etwas schief, kann es theoretisch sein, dass die DS nicht mehr richtig startet. Daher unbedingt Backups anfertigen.

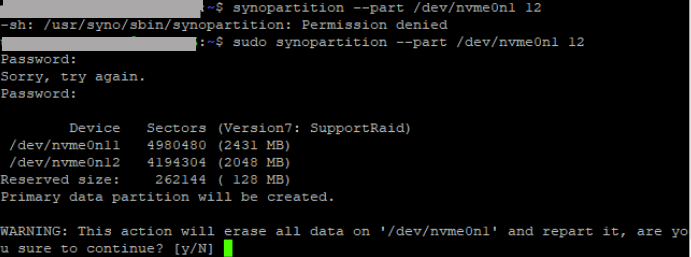

Wir nutzen dafür das folgende Kommando (Bei der Partitionierung des 2. NVME-Slots würden wir entsprechend /dev/nvme1n1 verwenden):synopartition --part /dev/nvme0n1 12

Die Ausführung des Kommandos musst du einmal mit “y” bestätigen.

Das Ergebnis sieht dann wie folgt aus:

Cleaning all partitions...

Creating sys partitions...

Creating primary data partition...

Please remember to mdadm and mkfs new partitions.

Um zu überprüfen, ob die Partitionierung funktioniert hat, können wir noch einmal “fdisk -l /dev/nvme0n1” eingeben.

Es werden dann – im Vergleich zur ersten Ausgabe zu Beginn – die entsprechenden Partitionen angezeigt.

4. Raid-Device erstellen

Damit der DSM etwas mit dem Volume anstellen kann, muss es sich um ein Raid-Device handeln.

Das können wir ganz einfach mittels “mdadm” machen.

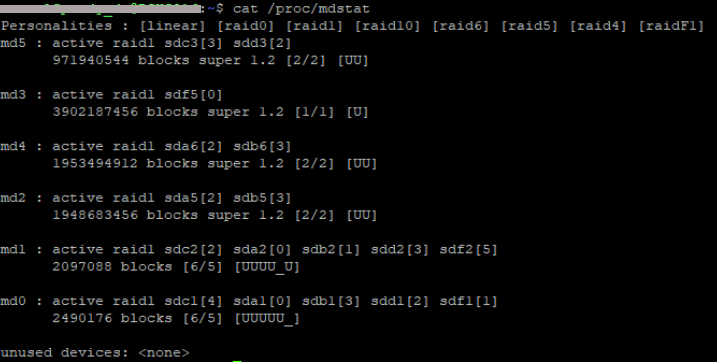

Zuerst müssen wir uns aber anschauen, welche Raid-Devices bereits auf dem System existieren:cat /proc/mdstat

Im Anschluss erstellen wir ein neues Raid-Device mit der nächsten freien Nummer. Die Nummer des Raid-Devices steht immer hinter dem “md”, also md0, md1, md2 usw. In meinem Fall gibt es bereits md0 bis md5, daher wähle ich für das zu erstellende Raid-Device “md6”:

mdadm --create /dev/md6 --level=1 --raid-devices=1 --force /dev/nvme0n1p3

Erläuterung des Befehls:

mdadm -> Befehl für die Nutzung des mdadm-Tools zur Verwaltung von Software-Raids

–create -> Wir wollen ein Software-Raid anlegen

/dev/md6 -> Welches Device soll für das Raid angelegt werden (hier: md6)

–level=1 -> Welches Raid Level soll erstellt werden?

–raid-devices=1 -> Wie viele physikalische Devices werden das Raid bilden?

–force -> Wir erzwingen die Erstellung

/dev/nvme0n1p3 -> Das/Die für das Raid verwendeten Hardware-Devices

Es lässt sich also natürlich auch ein Raid 1 mit 2 NVME-SSDs erstellen.

Dafür würde man lediglich den mdadm-Befehl wie folgt abändern:

mdadm –create /dev/md6 –level=1 –raid-devices=2 –force /dev/nvme0n1p3 /dev/nvme1n1p3

Spannend ist es hierbei zu sehen, dass md0 und md1 über sämtliche Festplatten/SSDs des Systems verteilte Raids sind. Es handelt sich hierbei um die Systempartition auf der das Betriebssytem (DSM) der Diskstation liegt, sowie die SWAP-Partition des Systems.

Dateisystem erzeugen

Mit folgendem Befehl erzeugen wir auf dem Raid-Device nun das Filesystem:mkfs.btrfs -f /dev/md6

Diskstation neu starten

Nun einmal die Diskstation neu starten und fertig.

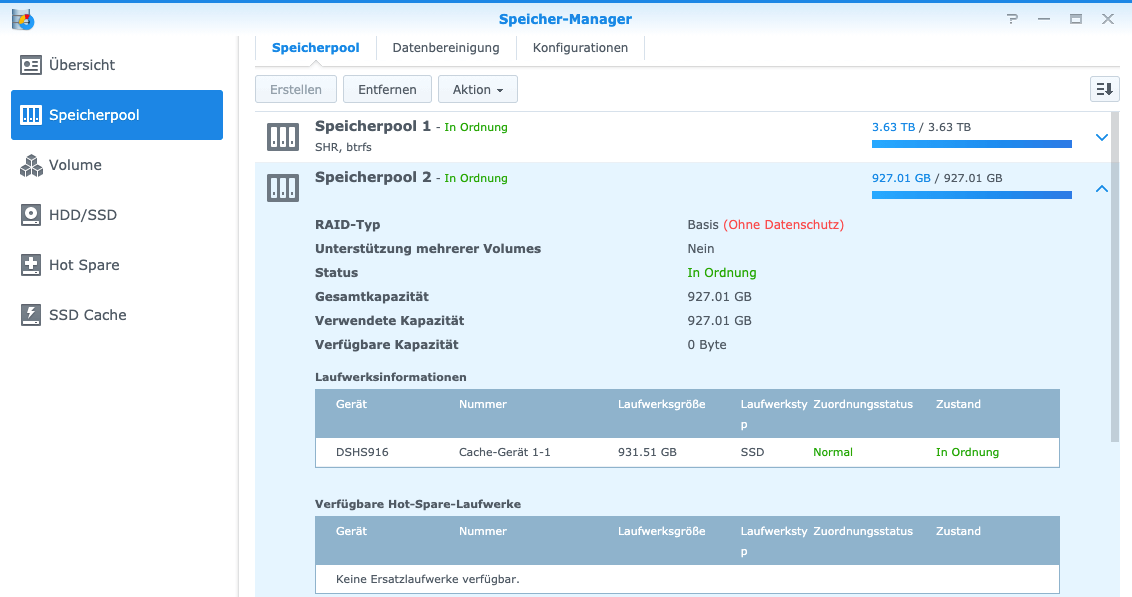

Das NVME-SSD-Volume ist nun erkannt und nutzbar.

Wenn das Laufwerk als btrfs-Volume formatiert wurde, kann es auch problemlos als Speicher für virtuelle Maschinen genutzt werden.

Die Nutzung von NVME-SSDs als Volume im Video

Mittlerweile gibt es das Tutorial auch im Video bei YouTube:

Performancetests

Ich habe mal ein btrfs-Volume auf einer DS3018xs erstellt und eine virtuelle Windows 10-Maschine auf das NVME-Volume gelegt.

Jetzt schauen wir mal, wie sich das Volume von der HDD/SSD-Performance her schlägt.

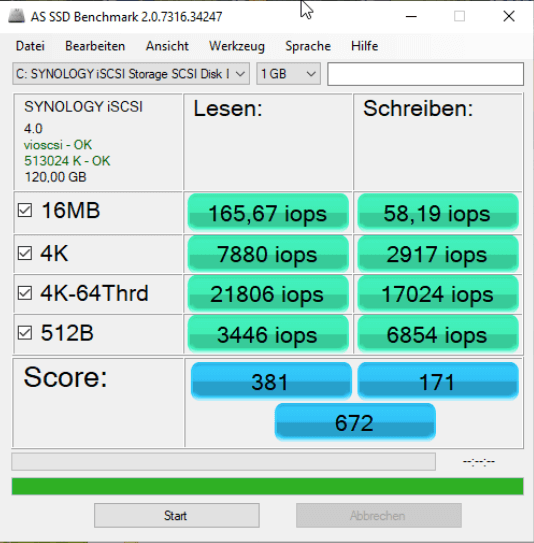

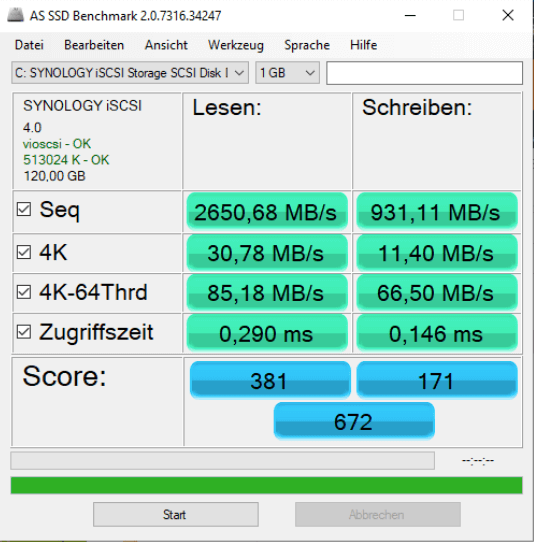

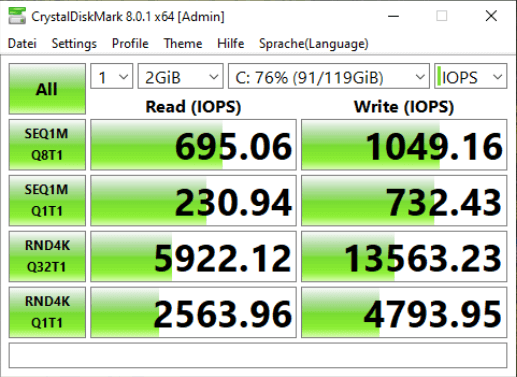

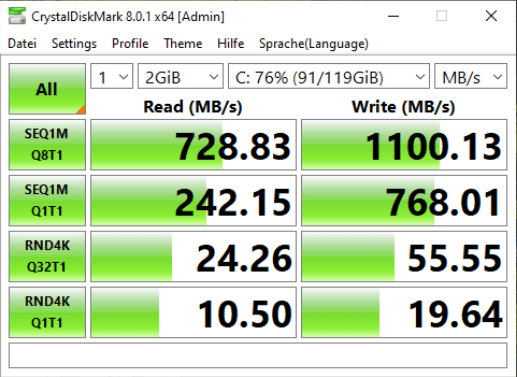

AS SSD Benchmark

Crystal Disk Mark

Quellen: https://www.reddit.com/r/synology/comments/a7o44l/guide_use_nvme_ssd_as_storage_volume_instead_of/

Letzte Aktualisierung am 2025-07-09 / Affiliate Links / Bilder von der Amazon Product Advertising API

Uwe Schmidt

Hi,

sehr schöne Beschreibung. Bei mir, eine DS920+ mit DSM7 funktioniert leider der mdadm Befehl nicht. Das Array wird zwar angelegt, ist nach einem reboot aber wieder weg. Die Partitionierung und das btrfs bleiben erhalten. In der Speicherübersicht heißt das dann “Verfügbarer Pool” ohne das man damit etwas machen kann.

Jan-Dirk

Vielen Dank für dein Feedback Uwe!

Leider habe ich keine Diskstation zur Hand, die DSM7 unterstützt (außer virtuelle DSM und da bringt das natürlich wenig ;))

Da es sich ja ohnehin um keine offizielle Funktion handelt, kann es durchaus sein, dass dieser Weg unter DSM7 nicht mehr funktioniert.

Sobald ich ein DSM7-Gerät zur Verfügung habe, werde ich das auch noch einmal probieren und dem auf den Grund gehen.

Gruß

Jan-Dirk

hellraver

Ich habe auch eine DS920+ und DSM 7 und konnte erfolgreich aus zwei verbauten NVME-SSDs ein Speicherpool im Raid 0 Verbund und anschließend ein funktionsfähiges Volume erstellen. Anschließend habe ich aus dem Paketzentrum, dass Synology „Virtual Machine Manager“ Paket installiert und auf das neu erstellte Volume mit den NVME-SSDs, eine Windows Server 2022 Installation erfolgreich eingerichtet.

Andreas

Hallo Uwe,

diesen Fehler hatte ich auch und mein “Trick” war, nicht gleich den Reboot durchzuführen, sondern u warten, bis mdadm das RAID fertig initialisiert hat. Startet man danach das RAID neu, ist der neue Speicherpool (noch) da.

Manfred

Danke. Funktioniert alles . Kann RAID 0 auf diese Weise gelöst werden? Was muss geändert werden? Danke sehr

Jan-Dirk

Hallo Manfred,

ja, du kannst auch ein Raid 0 erzeugen.

Dafür musst du einfach beim “mdadm –create”-Befehl level=0 als Raidlevel übergeben.

Ich muss aber zu bedenken geben, dass Raid 0 keine Redundanz und dafür eine doppelte Ausfallwahrscheinlichkeit bzw. zwei Single-Points-of-Failure hat.

Zudem ist es – aber das ist jetzt nur meine Hypothese – unwahrscheinlich, dass du einen Geschwindigkeitsvorteil merken wirst, da ohnehin die meisten NAS aufgrund anderer limitierender Faktoren (wie der CPU) bereits die Geschwindigkeit einer NVME-SSD kaum ausreizen können.

Dazu kommt, dass Raid 0 auf hohen Datendurchsatz ausgelegt ist – und hoher Datendurchsatz auf NVME-SSDs bedeutet sehr hohe Temperaturen. Die Kühlung der M2-Slots in Synology NAS ist dafür definitiv nicht ausgelegt und es kann zu massiven Hitze- und Stabilitätsproblemen kommen.

Dazu passend auch mein aktueller Beitrag, in dem ich von meinen massiven Problemen mit bestimmten NVME-SSDs in Synology NAS berichte 😉

https://addictedtocode.de/technik-hardware/wenn-das-nas-oder-der-pc-nach-dem-einbau-einer-nvme-ssd-einfriert/

Beste Grüße

Jan-Dirk

Bernd

Hallo Manfred,

ich habe nun auf meiner 923+ ebenfalls versucht mittels den o.g. Befehlen ein NVMe Volume als RAID1 zu erstellen.

Zum Einsatz kommen 2 Samsung 980 Pro 1 TB.

Habe die ganzen Befehle per SSH abgesetzt und es sah soweit auch alles gut aus.

Allerdings waren nach dem Reboot die beiden SSDs immer noch im Status “Nicht initialisiert” unter HDD/SSD im Speichermanager.

DSM-Version ist DSM 7.1.1-42962 Update 3

Hier ein paar Details aus Ausführung der Befehle:

root@NAS4US:~# fdisk -l /dev/nvme*n1

Disk /dev/nvme0n1: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

Disk model: Samsung SSD 980 PRO 1TB

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0x2dedXXXX

Device Boot Start End Sectors Size Id Type

/dev/nvme0n1p1 256 4980735 4980480 2.4G fd Linux raid autodetect

/dev/nvme0n1p2 4980736 9175039 4194304 2G fd Linux raid autodetect

/dev/nvme0n1p3 9437184 1953520064 1944082881 927G fd Linux raid autodetect

Disk /dev/nvme1n1: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

Disk model: Samsung SSD 980 PRO 1TB

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0x8291XXXX

Device Boot Start End Sectors Size Id Type

/dev/nvme1n1p1 256 4980735 4980480 2.4G fd Linux raid autodetect

/dev/nvme1n1p2 4980736 9175039 4194304 2G fd Linux raid autodetect

/dev/nvme1n1p3 9437184 1953520064 1944082881 927G fd Linux raid autodetect

–> Sieht gut aus

Mit folgendem Befehl habe ich dann das RAID auf der nächsten md-Nummer (bei mir md3) erstellt:

mdadm –create /dev/md3 –level=1 –raid-devices=2 –force /dev/nvme0n1p3 /dev/nvme1n1p3

Ergebnis

mdadm: /dev/nvme0n1p3 appears to be part of a raid array:

level=raid1 devices=2 ctime=Tue Jan 17 18:08:04 2023

mdadm: Note: this array has metadata at the start and

may not be suitable as a boot device. If you plan to

store ‘/boot’ on this device please ensure that

your boot-loader understands md/v1.x metadata, or use

–metadata=0.90

mdadm: /dev/nvme1n1p3 appears to be part of a raid array:

level=raid1 devices=2 ctime=Tue Jan 17 18:08:04 2023

Continue creating array? y

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md3 started.

–> sieht erst mal gut aus.

Prüfung nach dem Erstellen des RAID

cat /proc/mdstat

Personalities : [raid1]

md3 : active raid1 nvme1n1p3[1] nvme0n1p3[0]

972040384 blocks super 1.2 [2/2] [UU]

[>………………..] resync = 0.3% (3602048/972040384) finish=26.8min speed=600341K/sec

md2 : active raid1 sata1p3[3] sata2p3[2]

17573603328 blocks super 1.2 [2/2] [UU]

md1 : active raid1 sata1p2[0] sata2p2[1]

2097088 blocks [4/2] [UU__]

md0 : active raid1 sata2p1[0] sata1p1[1]

2490176 blocks [4/2] [UU__]

unused devices:

Zum Schluss dann noch Dateisystem erstellen:

mkfs.btrfs -f /dev/md3

Ergebnis

btrfs-progs v4.0

See http://btrfs.wiki.kernel.org for more information.

Performing full device TRIM (927.01GiB) …

Label: (null)

UUID: 5d579502-8329-4cd5-a0cb-XXXXXXXXXXXXX

Node size: 16384

Sector size: 4096

Filesystem size: 927.01GiB

Block group profiles:

Data: single 8.00MiB

Metadata: DUP 1.01GiB

System: DUP 12.00MiB

SSD detected: no

Incompat features: extref, skinny-metadata

Number of devices: 1

Devices:

ID SIZE PATH

1 927.01GiB /dev/md3

Nun per Reboot die NAS neu starten.

Nach dem Neustart waren wie gesagt die beiden SSDs nach wie vor nicht initalisiert.

Per SSH wurde folgendes Ergebnis angezeigt:

cat /proc/mdstat

Personalities : [raid1]

md2 : active raid1 sata1p3[3] sata2p3[2]

17573603328 blocks super 1.2 [2/2] [UU]

md1 : active raid1 sata1p2[0] sata2p2[1]

2097088 blocks [4/2] [UU__]

md0 : active raid1 sata2p1[0] sata1p1[1]

2490176 blocks [4/2] [UU__]

unused devices:

–> Wie man sieht, fehlt hier nun md3

Ich hatte die letzten Steps aus der Anleitung dann ein 2. Mal durchgeführt, jedoch mit dem gleichen Ergebnis.

Hast Du eine Idee, was ich noch tun kann, um die NAS zu überzeugen, mir ein SSD-Volume anzulegen?

Beste Grüße

Bernd

Bernd

Hallo Manfred,

meinen Post von gestern Abend kannst Du gerne auch löschen und nicht hier freigeben.

Ich habe den Fehler gefunden.

Der letzte Step im DSM Speicher Manager wurde nicht beschrieben.

Nach dem Neustart gibt es dort ja einen Eintrag “Verfügbarer Speicherpool 1”. Dieser ist im Speicher Manager über den Punkt “Online zusammenstellen” zu erstellen.

Bei mir hatte es im ersten Step zu einem Fehler geführt.

Im Protokoll wurde folgendes angezeigt:

Failed to assemble Available Pool [1] (RAID Type is [RAID 1]) with drive [M.2 Drive 1, M.2 Drive 2]

Nach einem erneuten Neustart der DS923+ war der Speicherpool dann allerdings vorhanden und scheint auch zu funktionieren.

Ergänze evtl. o.g. Beschreibung um diesen Step.

Viele Grüße

Bernd

Kai

Hallo ihr beiden,

ich habe 2 WD Red NAS NVME mit je 1 TB, die ich unter DSM 7.1.1 Update 4 als RAID 1 ins Sstem holen möchte.

Ich habe beide partitioniert, doch nun passiert folgendes:

# mdadm –create /dev/md2 –level=1 –raid-devices=2 –force /dev/nvme0n1p3 /dev/nvme1n1p3

mdadm: An option must be given to set the mode before a second device

(/dev/md2) is listed

md2 ist nächste freie nach md0 und md1, auch mit md3 funktioniert es nicht.

Was kann ich tun, welche “option” muss ist setzen?

fdisk -l /dev/nvme0n1

Disk /dev/nvme0n1: 931.5 GiB, 1000204886016 bytes, 1953525168 sectors

Disk model: WD Red SN700 1000GB

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: dos

Disk identifier: 0x4aaae45d

Device Boot Start End Sectors Size Id Type

/dev/nvme0n1p1 256 4980735 4980480 2.4G fd Linux raid autodetect

/dev/nvme0n1p2 4980736 9175039 4194304 2G fd Linux raid autodetect

/dev/nvme0n1p3 9437184 1953520064 1944082881 927G fd Linux raid autodetect

So sehen die beiden NVME aus.

Danke für die Hilfe,

Kai

Michael

Vielen Dank für diesen Hinweis, Bernd!

Wir haben es nicht direkt gefunden, aber unter Speicher-Manager wurde links unter “Speicher” — NICHT unter HDD/SSD — der “Speicherpool 1” wie von dir beschrieben angezeigt.

Zu beachten war, das “Online zusammenstellen” ein Link in dem Beschreibungstext war, den man leicht übersieht.

Nach dem Schritt wurde das neu erstellte md3 (in unserem Fall) dann auch wieder unter `cat /proc/mdstat` aufgeführt.

Viele Grüße

Michael

Ingo Klever

Hallo Manfred,

das erstellen eines Volumen hat auf meiner DS420+ (DSM 7.1) sehr gut geklappt. Die VM’s auf dem Volume laufen auch wesentlich performanter als auf den HDD’s.

Nun meine Frage:

Verbaut sind 2 M.2 SSD mit 500Gb. Ich würde gerne die SSD’s aufteilen. 250 GB für den Schreib und Lesecache. 250 Gb für das Volume (RAID 1).

Kennst Du eine Vorgehensweise, mit der das möglich ist?

Viele Grüße

Ingo

Jan-Dirk

Hallo Ingo, das ist so leider nicht möglich 🙁

Wenn SSDs für den Cache genutzt werden, kann man sie – auch nicht zu teilen – als Volume nutzen 🙁

Beste Grüße

Jan-Dirk

Roland

Hallo zusammen, Anleitung hat Super geklappt bei meiner neuen DS923+ (migriert von DS716+).

– DSM 7.1.1-42962 Update 4

– 2 x Samsung SSD M.2 NVMe 970 EVO Plus 1TB (1 dafür verwendet)

Nach Reboot der DS kam jedoch “System hat erkannt, dass verfügbarer Pool 1 zusammengestellt werden kann. Für weitere Informationen gehen Sie bitte zum Speicher-Manager.”

Ein klick auf “Online zusammenstellen” im Burger-Menü genügte um der neue Speicherpool war in Ordnung. Siehe https://kb.synology.com/de-de/DSM/help/DSM/StorageManager/storage_pool_online_assemble?version=7

Danke an alle beteiligten…

Grüße aus Nürnberg

Roland

Jan-Dirk

Klasse, dass bei dir alles geklappt hat 🙂

Vielen Dank für deine Rückmeldung!

Jan

Hi,

habe meine beiden NVMe SSDs auf die beschriebene Art zum Volume gemacht. Jetzt zeigt das NAS eine als defekt an. Ersatz habe ich schon bestellt (2x 500Gb statt 2x 250 wie aktuell)

Wie gehe ich denn jetzt am besten vor um die defekte SSD auszutauschen und dann die 500Gb nutzbar zu machen?

Oliver Kuhlmann

Hallo,

ich habe bisher eine M2.SSD als Laufwerk für eine Virtuelle Maschine benutzt und das hat auch einwandfrei funktioniert nach Deiner Anleitung. Nun habe ich gestern ein Update des DSM gemacht und jetzt ist das Volume weg und die Diskstation sagt dass die SSD als Cache-Laufwerk nicht unterstützt wird, so wie wenn man sie neu eingebaut hätte. Die Partitionenen sind mit Sicherheit noch auf der SSD aber wie binde ich diese wieder als Volume ein. Sorry für die Anfängerfrage aber ich bin in Linux nicht sehr erfahren.

Danke für die Hilfe

Oliver Kuhlmann

Hallo nochmal ich,

Plötzlich ist das Volume von alleine wieder da und auch die Virtuelle Machine läuft wieder. Hat nach dem DSM Update ca. ne Stunde gedauert. Ich habe keinen Neustart der Diskstation gemacht. Also “überlebt” dieser Hack auch ein DSM Update (Zumindest in meinem Fall) auf DSM 7.2-64570 Update 1.

Grüße

Jonathan

Hallo Oliver,

hast du das Laufwerk erstmalig unter DSM 7.1 oder 7.2 eingebunden?

Welches SSD war das?

Danke,

Jonathan

Jens Kneschke

Nachdem es Monate gut gelaufen ist war nach einem Neustart auf einmal mein Volume3 nicht mehr verfügbar. Bei den Cache SSDs steht “Von aktueller DSM Version nicht unterstützt” und ein online zusammenstellen ist nicht mehr möglich.

Hmmm und was mach ich nun? Ich habe Homeassistant als virtuelle Maschine darauf laufen.

AiMwasNeD

Ich habe leider dasselbe Problem wie Oliver. Nach dem DSM 7.2-64570 Update 1 ist die M2 leider nicht mehr eingebunden. 3 Std. später hat sich daran auch nichts geändert. Gibt es eine Möglichkeit die M.2 einfach wieder einzubinden, ohne zu formatieren etc.?

AiMwasNeD

Nachtrag zu meinen ersten Post:

Problem gelöst! Habe das Synology HDD db Script benutzt, danach den defekten Pool gelöscht. Der gelöschte Pool popt aber dann erstaunlicherweise direkt wieder auf inkl. funktionsbereiter Volume. Mag unlogisch erscheinen, hat aber geklappt.

Maximilian Schneider

Vielen Dank für den Tipp.

Nach einem Update meines DS420+ mit 4x4TB HDDs und 2 x 1TB Samsung nvme konnte ich SP2 (mit diesem Artikel aus den Cache Drives erzeugt) nicht mehr verwenden. Nachdem ich das 007revad/Synology_HDD_db script von Github ausgeführt und neugestartet habe, war der Pool automatisch wieder da und alle darauf installierten Pakete (inkl. VMs) liefen sofort.

Vielen DANK!!!!

Andreas

Hallo Leute, für diejenigen, die nicht wissen, wo das besagte Skript zu finden ist – hier der Link:

https://github.com/007revad/Synology_HDD_db

Hat bei mir letzte Woche (noch) gut mit dem aktuellsten DSM 7.2 funktioniert 🙂

Frank

wie mache ich per ssh aus /dev/nvme0n1p3 und /dev/nvme1n1p3 ein raid1 ohne die Daten von der synology zu verlieren. dies wurde bereits ursprünglich als Raid1 konzipiert aber jetzt funktioniert das ganze nicht mehr

Jonathan

Hallo,

ich hab die Originalanleitung aus dem Reddit-Link verwendet.

DS920+; 2x Ironwolf 510 480GB; beide als Basic Disc gelaufen.

Lief drei Jahre ohne Probleme mit mehreren Updates. Hab gestern DSM 7.2 installiert. Jetzt ist mein Pool weg; die “Online Anmeldung” der beiden Pools (2 und 3) funktioniert nicht.

Und im Speichermanager steht bei den beiden Cachegeräten “von aktueller DSM-Version nicht unterstützt”.

Chris

Meine DS920+ hat heute auf DSM 7.2.1-69057 Update 1 geupdated und dabei mein RAID0 auf den NVME-Plätzen geschrottet. Wenn ich nur das Software-Raid wieder anlege, verschwindet es nach einem Neustart, also habe ich den kompletten Prozess nochmal durchlaufen und dabei die Daten gelöscht. Jetzt überlebt das RAID einen Neustart, aber in der UI steht immer nur bei den Laufwerken “Von aktueller DSM-Version nicht unterstützt” und ich kann rein gar nichts mehr mit den Laufwerken anstellen.

Ich musste folgendes machen: Das RAID löschen, in der UI die Laufwerke “zurücksetzen”. Neustart. Den Prozess hier komplett durchlaufen. Neustart. In der UI den Pool wieder aktivieren. Backup zurückspielen.

Wenn das bei jedem Update so ist, dann gute Nacht.

Jan-Dirk

Hallo Chris,

ja, das ist dann wirklich ungünstig.

Man muss halt wirklich immer betonen, dass es sich um eine Bastellösung handelt und das ganze ohne Kommentar bei JEDEM Update von Synology geändert werden kann :/

Afaik bietet Synology seit DSM 7.1 aber sogar die Möglichkeit an (bei ausgewählten Modellen?) offiziell NVMWE-Laufwerke als Volumes zu nutzen.

Beste Grüße

Jan-Dirk

Burkhard Landwehr

Bei mir nutzt das Script nichts, das Volume wird weiterhin auch nach Neustart als fehlerhaft angezeigt. Die darauf installierten VM´s funktionieren einwandfrei. Man kann auch neue erstellen.

Gruß

Burkhard